Introduction

Dans les articles à venir, nous allons mettre en place une architecture complète basée sur les solutions VMware qui pourra être utilisée pour des LABs, des démonstrations, des environnements de test ou des POCs. Nous utiliserons du matériel spécifiquement dédié au développement et aux tests. Cette architecture est facilement adaptable pour des environnements de production moyennant quelques modifications apportées à certains éléments.

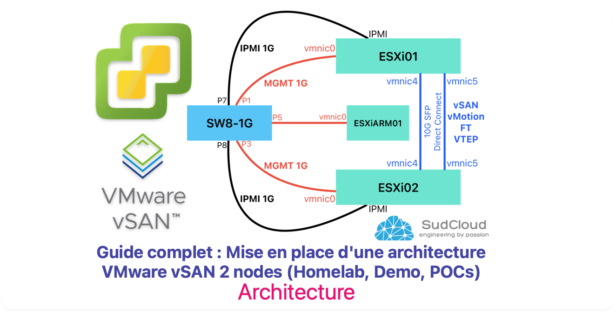

Pour commencer, nous allons concevoir notre future architecture. Le schéma est important car il nous permet d’anticiper d’éventuelles erreurs de câblage, de dimensionnement réseau, de redondance ou autres…

Architecture

Nous allons décrire élément par élément leur rôle dans notre architecture ainsi que le choix du matériel physique.

Les serveurs ESXi

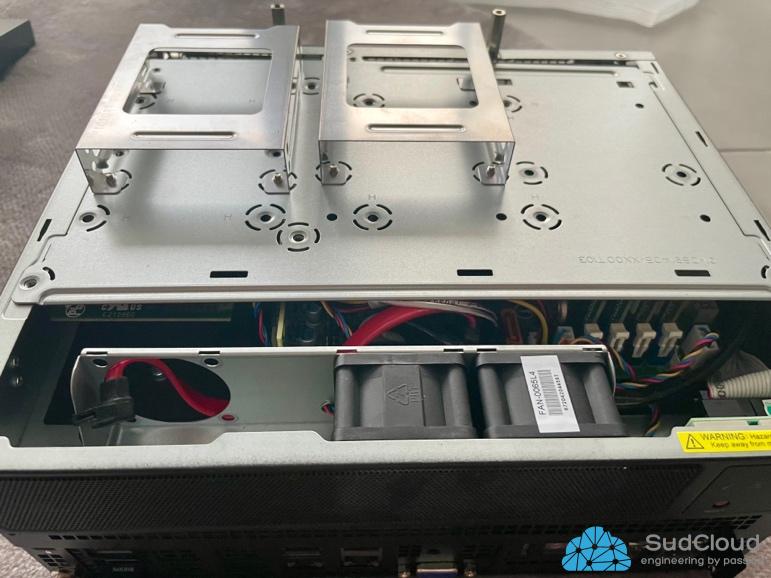

Pour ce nouveau LAB, le choix s’est orienté vers des serveurs de la marque SUPERMICRO, car mon ancien LAB tournait avec des cartes mère de cette marque et je n’ai eu aucun souci pendant 5 ans en tournant 7j/7 et 24h/24.

Le model choisi est le A+ Server E301

Il permet d’avoir des performances exceptionnelles avec son CPU AMD EPYC ainsi que la possibilité de supporter jusqu’à 4 SSD/HDD SATA en 2.5 pouces et 512GB de RAM !

Une carte PCI Ethernet DUAL 10G SFP a été rejoutée pour nous permettre de faire du direct connect entre nos ESXi et ainsi avoir une bande passante importante pour notre trafic vMotion, vSAN, Fault tolérance et VTEP pour nos futurs segments NSX.

La connexion directe de nos ESXi nous permet de nous passer de l’achat d’un switch 10Gb, ce qui peut faire grimper la facture de notre environnement. De plus, cette architecture est prise en charge pour les installations de vSAN en deux nœuds, il est donc judicieux d’en profiter.

L’installation de l’ESXi se fera quant à elle directement sur nos modules SATADOM de 64Gb et non plus sur une clé USB, car depuis les dernières versions de VMware, l’utilisation de clé USB ou de carte SD n’est plus supportée.

L’avantage des cartes mère SUPERMICRO est la possibilité de brancher les modules de stockage SATADOM directement sur un port SATA auto alimenté (couleur orange).

Raspberry PI

Le Raspberry PI 3 nous permettra d’installer la version ARM de l’ESXi et ainsi pouvoir l’utiliser en tant que Witness pour notre cluster vSAN. Il est nécessaire de l’accompagner avec au moins 2 clés USB ou de deux disques SATA branchés en USB.

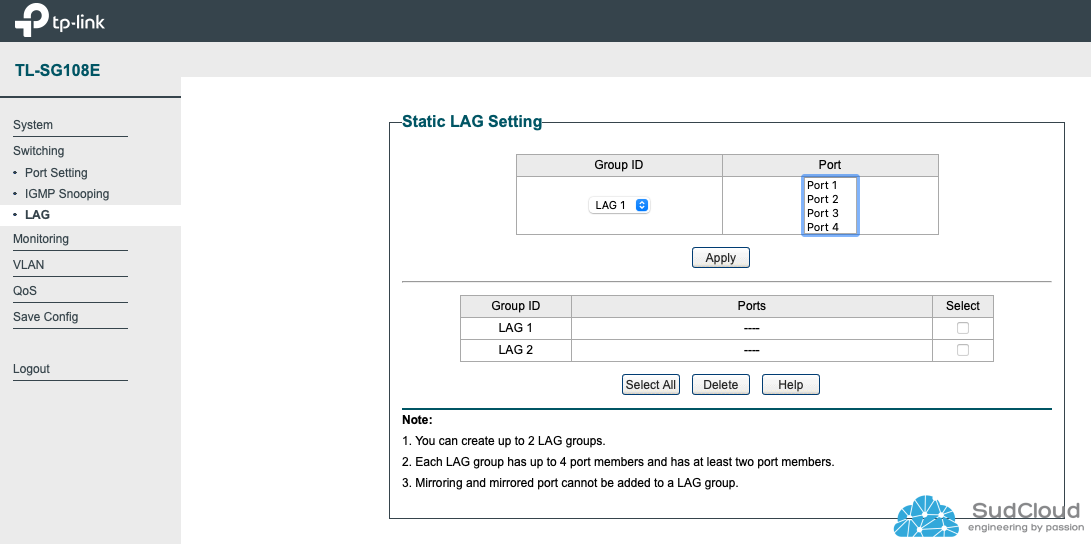

Switch réseau 1G

Un switch réseau est indispensable pour connecter nos ESXi et garantir une communication fluide entre eux. Il nous permettra également de nous connecter à nos équipements depuis notre réseau domestique ou professionnel. Dans mon cas, j’ai utilisé un ancien switch TP-Link TL-SG108E que j’avais à disposition. Les points forts de ce switch sont la possibilité de l’administrer via une interface web, la gestion des VLANs et la prise en charge de l’agrégation de ports pour maximiser la bande passante.

Stockage

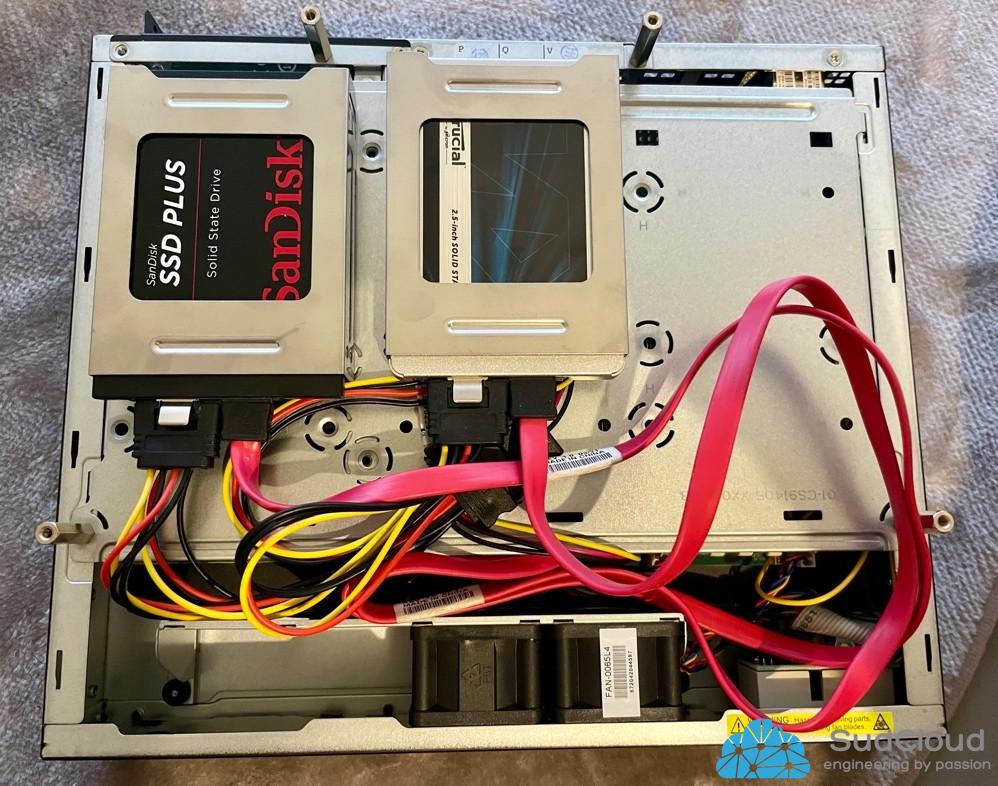

Il est crucial de dimensionner correctement notre vSAN. Dans notre cas, avec une architecture en deux nœuds, nous devrons utiliser un RAID 1 pour nos ESXi. Cela signifie que notre ESXi01 sera un miroir de notre ESXi02. Aucun RAID matériel n’est requis dans chacun de nos ESXi. Nos disques seront présentés directement à notre ESXi qui se chargera de protéger nos données vers l’autre ESXi. J’ai opté pour un disque NVME de 480 Go pour le disque de cache.

J’ai fait le choix d’utiliser un disque de 2Tb SSD ainsi qu’un disque de 480Gb SSD en SATA pour les disques de capacités. L’avantage de vSAN est la scalabilité, ce qui veut dire qu’on pourra facilement augmenter la taille de notre datastore vSAN simplement en rajoutant de nouveaux disques dans nos ESXi.

Récapitulatif

Nodes | Disque de cache | Disques de capacité |

ESXi01 | 1 x 480Gb NVME | 1 x 2Tb SSD SATA 1 x 480Gb SSD SATA |

ESXi02 | 1 x 480Gb NVME | 1 x 2Tb SSD SATA 1 x 480Gb SSD SATA |

ESXiARM01 | 1 x 32Gb USB3 | 1 x 128Gb USB3 |

Configuration réseau

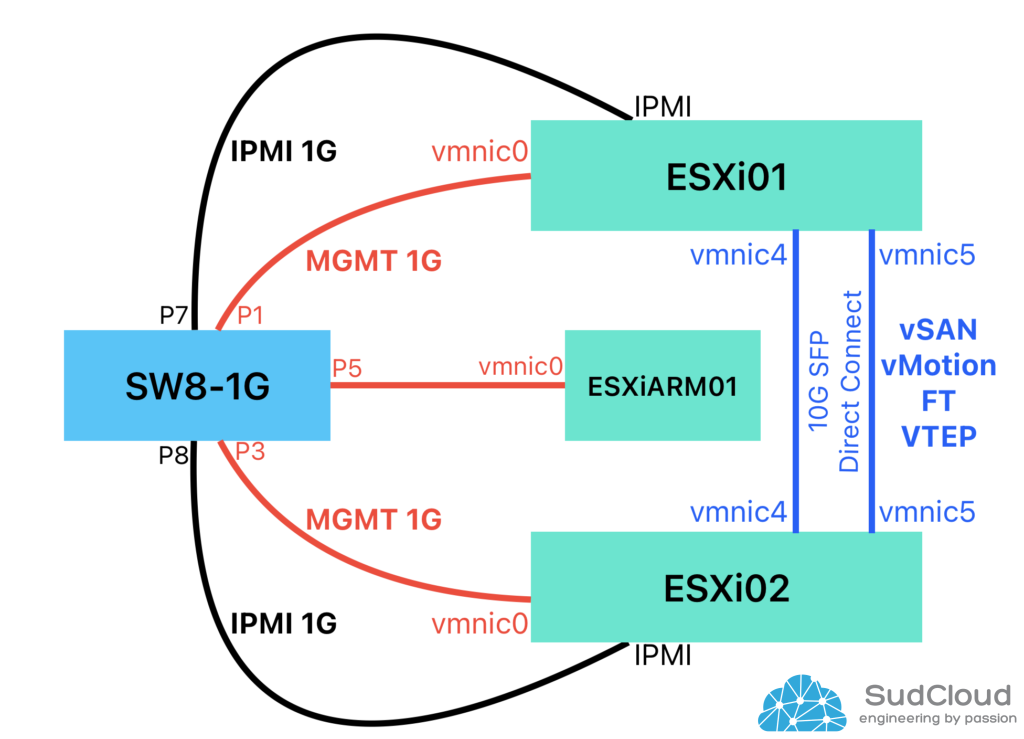

Configuration des liaisons

Sources | Port source | Destination | Port destination | Description |

ESXi01 | IPMI | SW8-1G | P7 | MGMT IPMI |

vmnic0 | SW8-1G | P1 | MGMT ESXi | |

vmnic4 | ESXi02 | vmnic4 | vMotion, vSAN, FT, VTEP | |

vmnic5 | ESXi02 | vmnic5 | vMotion, vSAN, FT, VTEP | |

ESXi02 | IPMI | SW8-1G | P8 | MGMT IPMI |

vmnic0 | SW8-1G | P3 | MGMT ESXi | |

vmnic4 | ESXi01 | vmnic4 | vMotion, vSAN, FT, VTEP | |

vmnic5 | ESXi01 | vmnic5 | vMotion, vSAN, FT, VTEP | |

ESXiARM01 | vmnic0 | SW8-1G | P5 | MGMT ESXi |

SW8-1G | P6 | Routeur | Port routeur | LAN Maison / Entreprise |

Configuration des IPs

Équipement | Description | IP | Masque | GW |

ESXi01 | IPMI | 192.168.0.252 | /24 | 192.168.0.254 |

MGMT | 192.168.0.11 | /24 | 192.168.0.254 | |

vMotion | 192.168.201.11 | /24 | N/A | |

vSAN | 192.168.202.11 | /24 | N/A | |

FT | 192.168.203.11 | /24 | N/A | |

VTEP | 192.168.204.11 | /24 | N/A | |

ESXi02 | IPMI | 192.168.0.253 | /24 | 192.168.0.254 |

MGMT | 192.168.0.12 | /24 | 192.168.0.254 | |

vMotion | 192.168.201.12 | /24 | N/A | |

vSAN | 192.168.202.12 | /24 | N/A | |

FT | 192.168.203.12 | /24 | N/A | |

VTEP | 192.168.204.12 | /24 | N/A | |

ESXIARM01 | MGMT | 192.168.0.13 | /24 | 192.168.0.254 |

SW8 | MGMT | 192.168.0.251 | /24 | 192.168.0.254 |

vCenter | MGMT | 192.168.0.10 | /24 | 192.168.0.254 |

DNS1 : 192.168.0.1

Conclusion

Dans les prochains articles, nous verrons techniquement comment mettre en place cette nouvelle architecture.